Google louche sur les formulaires Internet

Le Deep web, c’est toutes les informations qui ne sont pas référencées par les moteurs de recherche, Google en tête. Des informations provenant de formulaires, d’espaces que les administrateurs, webmasters veulent garder sous leur contrôle, sans diffusion, ni référencement. Sauf que le géant américain Google est en train de regarder comment lire ces informations.

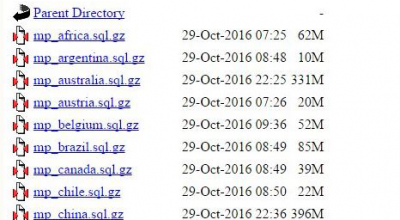

Le Web profond, le Deep web, est ce contenu caché, que les moteurs de recherche ne peuvent lire. Seulement, le Deep Web représente une grande partie des données structurées sur le Web. Accéder au contenu du Deep Web est un défi de longue date pour les amateurs de base de données. Google a décidé de se lancer dans l’extraction des données du Deep Web. Un document de l’université de Cornell décrit un système de lecture, et donc de copie, de contenus venus du Deep Web. Plusieurs milliers de requête seconde ! Les chercheurs universitaires montrent dans un document comment leur processus pourrait permettre de taper dans les BDD de boutiques, de sites Internet histoire de mieux référencer ce petit monde. Le document décrit également comment, les recherchent, tentent d’essayer de filtrer le contenu des pages afin d’éviter les réponses sans contenu ou reproduisant le contenu sous un nom différent. A lire l’analyse passionnante de SEO by the Sea.

La petite bête qui monte, qui monte…

Google avance, à petit pas, mais avance. Pour ce qui concerne les avancées du « crawl » du géant américain de l’Internet sur le reste du web non surfacique, il y a aussi des avancées notables concernant le JavaScript. Gary Illyes de Google a annoncé qu’il ne serait bientôt plus utile d’utiliser des « escaped fragments » pour servir au bot des versions statiques de contenus ajax. La fin du support Ajax pour Google ? Non, au contraire. Le bot sera capable d’effectuer le rendu sans passer par les escaped fragments, tout simplement.

Un exemple, il y a quelques jours, il a été constaté sur le site respond.ly (dans le code source de la page, NDR) que le cache Google contenait une copie intégrale de la home parfaitement rendue. Depuis, respond.ly a changé son fusil d’épaule et a fait de manière à éviter le crawl. Dorénavant, le cache de Google propose une page 404. Mais, pas de doute, l’idée de Google est une petite bête qui monte, qui monte, qui monte. (Un grand merci à Mathieu JANIN pour ses lumières).